إليك كيفية قيام Arm بتسريع أعباء عمل الذكاء الاصطناعي

في المشهد التكنولوجي سريع التغير اليوم، يتيح لنا التعلم الآلي والذكاء الاصطناعي إعادة تعريف الصناعات وتغيير طريقة تفاعلنا مع العالم. يتيح الذكاء الاصطناعي للمطورين إنشاء تطبيقات أكثر ذكاء ومرونة وكفاءة. قامت شركة Arm، نظرًا لموقعها الفريد في الصناعة، بتمكين الذكاء الاصطناعي عبر مجموعة متنوعة من المنصات لأكثر من عقد من الزمن.

في هذه المقالة، أريد أن أشرح بالتفصيل كيف تسمح تقنية Arm للمطورين بالتركيز على الابتكار والجوانب الفريدة للتطبيقات التي يقومون بتطويرها أثناء استخدام تقنية Arm الحالية.

لا تحتاج إلى NPU لتطبيقات الذكاء الاصطناعي

منذ أكثر من سبع سنوات، كنت أقوم بإنشاء محتوى حول مزايا وعيوب مسرعات التعلم الآلي المختلفة – والتي تسمى NPUs. هذه المعالجات لها مكانها في الأجهزة، ولكن إحدى الخرافات هي أنك تحتاج إلى معالج لتشغيل مهام التعلم الآلي أو الذكاء الاصطناعي. هذا ببساطة غير صحيح. لا تتوقف مهام الذكاء الاصطناعي حصريًا على وحدات المعالجة العصبية؛ يمكنهم تشغيل أي شيء من وحدة المعالجة المركزية إلى وحدة معالجة الرسومات. باستخدام التقنية الموجودة في شرائح Arm v8 وArm v9، يمكنك تشغيل مهام التعلم الآلي المتسارعة بشكل جيد بشكل خاص على وحدات المعالجة المركزية Arm.

يعد مضاعفة المصفوفة العملية الرياضية الأساسية في قلب التعلم الآلي والذكاء الاصطناعي. تعتبر وحدات معالجة الرسومات ووحدات NPU جيدة في مضاعفة المصفوفات. ومع ذلك، فإن وحدات المعالجة المركزية Arm الحديثة جيدة أيضًا في مهمة المعالجة هذه ولديها مسرعات أجهزة تمكنها أيضًا. سواء كانت معالجات Arm v8 أو Arm v9 أو Cortex-A أو Cortex-X أو معالجات Arm’s Neoverse، فإن جميعها تتمتع بتقنيات مختلفة تسمح بتسريع عمليات ضرب المصفوفات.

على سبيل المثال، تتوفر كل من تقنية Arm’s Neon وScalable Vector Extensions (SVE) في معالجات Arm، وهناك أيضًا تعليمات ضرب مصفوفة بمصفوفة 8 بت في مجموعة تعليمات Arm. في الهواتف الذكية والأجهزة المتطورة، تتوفر امتدادات المصفوفة القابلة للتطوير (SME) داخل معالجات Arm. تتيح هذه التقنيات لوحدة المعالجة المركزية إجراء عمليات مصفوفة متسارعة بدون وحدة معالجة الرسومات (GPU) أو وحدة المعالجة العصبية (NPU).

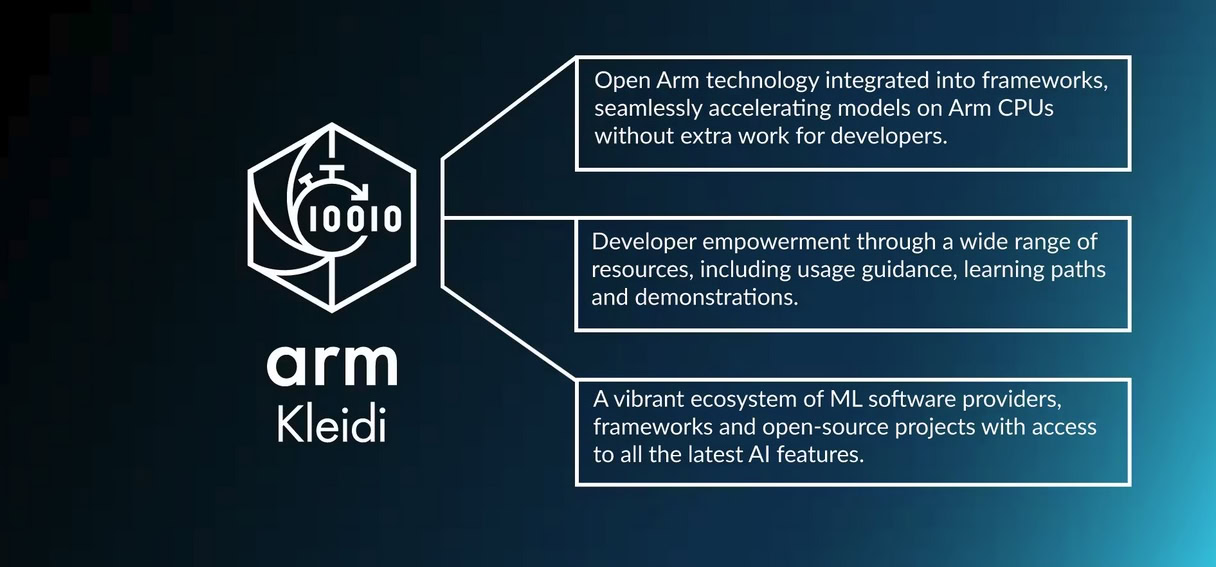

تقنية آرم كليدي

ما وراء أنظمة الأجهزة، كليدي يعد جزءًا أساسيًا من استراتيجية Arm لتمكين الذكاء الاصطناعي على منصات الأجهزة المحمولة والخوادم المستندة إلى Arm. وهو يغطي مجموعة من الموارد والشراكات لمساعدة المطورين على تسريع الذكاء الاصطناعي بسلاسة على Arm، بما في ذلك مكتبة من نواة التعلم الآلي عالية الأداء تسمى KleidiAI، والتي تم تحسينها لوحدات المعالجة المركزية Arm باستخدام مسرعات الأجهزة المختلفة.Kleidi متاح على GitLab، وقد تم دمج هذه النوى في أطر عمل مختلفة جاهزة للمطورين للاستخدام. ونتيجة لذلك، لدينا الآن تسريع الأجهزة لوحدات المعالجة المركزية Arm، مما يدعم تقنيات التعلم الآلي المختلفة، بدءًا من التعلم الآلي الكلاسيكي وحتى الذكاء الاصطناعي التوليدي الحالي.

قامت شركة Arm بدمج تقنية Kleidi في أطر عمل الذكاء الاصطناعي الشائعة مثل PyTorch وExecuTorch، مما أدى إلى تحسينات كبيرة في الأداء الجاهز للمطورين. يضمن هذا التكامل أن المطورين يمكنهم الاستفادة بسلاسة من مكتبات Arm المحسّنة ضمن سير العمل الحالي لديهم، مما يؤدي إلى تحسين الأداء بما يصل إلى 12x بأقل جهد.

الذراع في شراكة مع ميتا للتأكد من أن طراز Llama 3.2 الذي تم إطلاقه مؤخرًا يعمل بشكل مثالي على وحدات المعالجة المركزية Arm. يعد توفر دورات LLM أصغر حجمًا، والتي تتيح أعباء عمل الذكاء الاصطناعي التوليدي الأساسي المستند إلى النصوص، مثل إصدارات المعلمات التي تبلغ مليارًا وثلاثة مليارات، أمرًا بالغ الأهمية لتمكين استدلال الذكاء الاصطناعي على نطاق واسع. يمكن لوحدات المعالجة المركزية للذراع تشغيل نماذج أكبر، مثل Llama 3.2 مع 11 مليار معلمة وحتى نموذج معلمة 90 مليارًا في السحابة. تعد هذه النماذج الأكبر حجمًا مناسبة بشكل ممتاز لأحمال عمل الاستدلال المستندة إلى وحدة المعالجة المركزية في السحابة والتي تولد النصوص والصور.

يمكن لإصدار Llama 3.2 الذي يحتوي على 11 مليار معلمة، والذي يعمل على معالج Amazon AWS Graviton4، تحقيق 29.3 رمزًا مميزًا في الثانية أثناء مرحلة الإنشاء، وهذا فقط على وحدة المعالجة المركزية. بفضل التعاون بين Arm وMeta في إطار عمل ExecuTorch، يمكنك الآن الوصول إلى الأداء الأمثل من خلال تشغيل تلك النماذج على الحافة. تشغيل Llama 3.2 3 مليار LLM الجديد على هاتف ذكي يعمل بالذراع من خلال تحسينات وحدة المعالجة المركزية Arm، يؤدي ذلك إلى تحسن بمقدار 5x في المعالجة السريعة وتحسين 3x في إنشاء الرمز المميز، مما يحقق 19.92 رمزًا مميزًا في الثانية خلال مرحلة التوليد.

إذا كنت تريد توضيحًا لهذا، فراجع الفيديو الخاص بي أعلاه.

دفعة هائلة للمطورين

وبفضل هذه التطورات، أصبحت الإمكانيات المتاحة للمطورين هائلة. فكر في كل ما يمكنك فعله باستخدام نموذج لغة كبير يعمل على الهاتف باستخدام وحدة المعالجة المركزية Arm – بدون وحدة معالجة رسومات، ولا وحدة NPU، ولا سحابة، فقط وحدة المعالجة المركزية. يتمثل نهج Arm في قابلية نقل الأداء، مما يعني أن مطوري الذكاء الاصطناعي يمكنهم تحسين نماذجهم مرة واحدة ثم نشر نماذجهم عبر منصات مختلفة دون إجراء أي تعديلات. يعد هذا مفيدًا بشكل خاص للمطورين الذين يحتاجون إلى نشر النماذج على الحافة وفي الهاتف الذكي وفي السحابة. باستخدام Arm، يمكن للمطورين التأكد من أن نموذجهم سيحقق أداءً جيدًا أيضًا على الأنظمة الأساسية الأخرى بمجرد تحسينه لمنصة واحدة.

الذراع لديه بعض عظيم الموارد للمطورين، بما في ذلك الوثائق المتعلقة بكيفية تسريع أحمال عمل الذكاء الاصطناعي والتعلم الآلي عندما تختار تشغيلها على وحدات المعالجة المركزية Arm، بالإضافة إلى تشغيل الذكاء الاصطناعي والتعلم الآلي على أجهزة Android.